Geradezu erstaunlich sind die Bilder, die die neueste Generation von Tools wie Dall-E 2 hervorbringt. Sie scheinen von Bildern, die von Menschen gezeichnet, fotografiert und konzipiert worden sind, kaum mehr unterscheidbar. Was läuft da hinter den Kulissen ab? Was bedeutet das alles für die Kreativbranche? Und welche Konsequenzen sollen wir daraus ziehen?

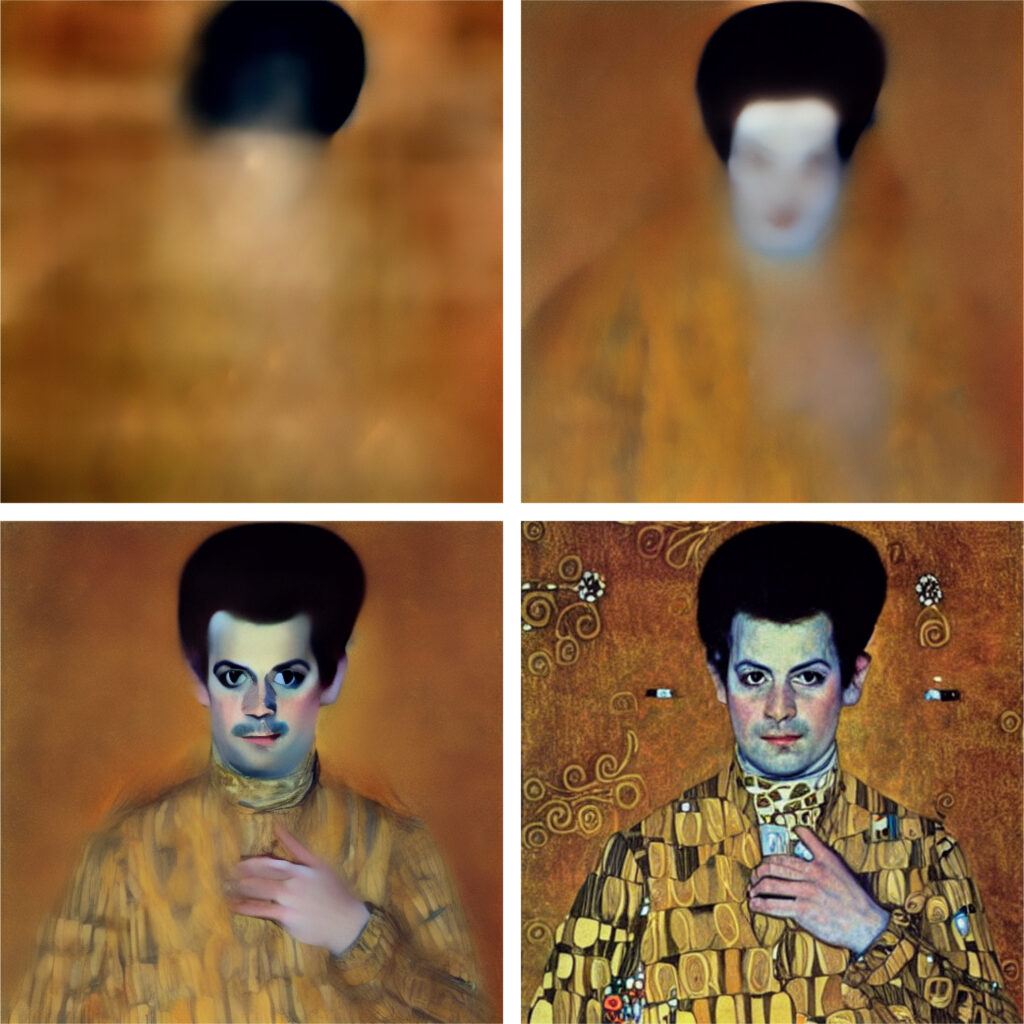

Wie aus Rauschen Bilder werden

Machine Learning? Artificial Neural Networks? Diffusion Models? Wer verstehen möchte, wie Dall-E und Co aus Prompts Bilder machen, ist mit einer Reihe nebulöser Begriffe konfrontiert. Hier eine kurze Einführung in die Mechanik hinter den Kulissen.

Computer sind lästige Geräte. Damit sie machen, was wir wollen, muss ihnen erstmal ein*e Programmierer*in Schritt für Schritt vorschreiben, was sie tun sollen, wenn sie Befehl X bekommen. Machine Learning ist der Versuch, einen Teil dieser Arbeit an den Computer auszulagern. Statt Schritt-für-Schritt-Anweisungen zu geben, wird ein grobes Framework erstellt und dieses Framework dann automatisch immer mehr verfeinert, bis es das gewünschte Ergebnis erzielt.

Artificial Neural Networks sind Teil dieser Frameworks. Sie bestehen aus einer Reihe von Knotenpunkten, genannt Neuronen, und Verbindungen zwischen diesen Neuronen. Jede Verbindung hat ein zugehöriges Gewicht, das bestimmt, wie stark zwei Neuronen miteinander verbunden sind. Beim Training von neuronalen Netzwerken passiert im Grunde nichts anderes als das stufenweise, automatische Anpassen Zigtausender dieser Gewichte in einem System von mathematischen Formeln.

Bei Dall-E, Midjourney und Stable Diffusion basiert dieses Training auf Diffusion Models. Zunächst wird ein Korpus von Bildern mit dazugehörigen Textbeschreibungen erstellt. Dann werden die Bilder schrittweise mit zufälligem Rauschen versehen. Das neuronale Netzwerk kriegt dann das verrauschte Bild vorgelegt und soll – etwas vereinfacht – für jedes Pixel bestimmen, ob es wahrscheinlicher Rauschen oder Bild ist. Dieser Output wird schließlich mit dem Originalbild verglichen und es werden die Parameter entsprechend angepasst. Das geschieht alles automatisch, tausende Male für Tausende von Parametern und Tausende von Bildern. Ziel ist es, am Ende ein Netzwerk zu haben, das so gut darin ist, Rauschen zu entfernen, dass es selbst bei einem Bild, das nur noch aus Rauschen besteht, allein anhand einer Textbeschreibung bestimmen kann, wie dieses fiktive Bild ausgesehen haben könnte.